大模型数据隐私问题得以破解 | 金智塔科技发布联邦学习大语言模型(FederatedLLM)最新研究成果!

金智塔

2023-09-12

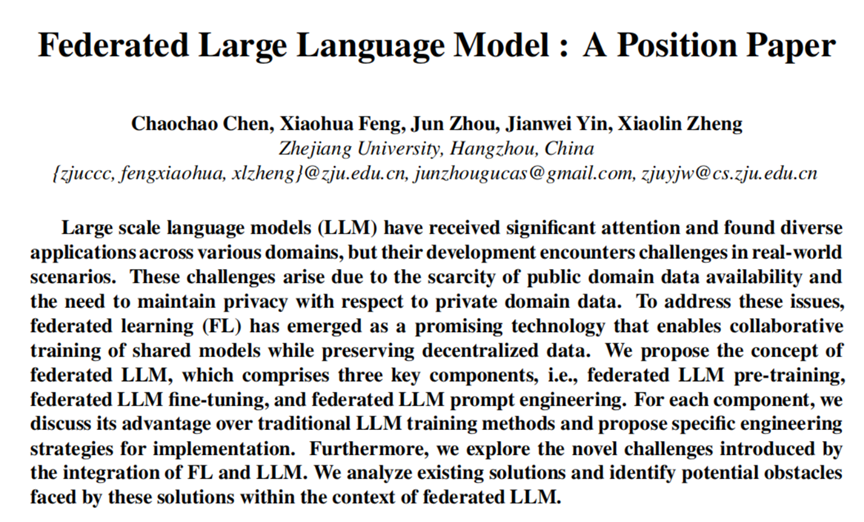

面对着公共领域数据的稀缺性以及私有领域的数据隐私问题,联邦学习(FL)作为一种分布式的机器学习框架吸引了许多关注。而伴随着大模型的出现与逐渐成熟,针对大规模语言模型(LLM)对更大规模训练数据的依赖以及数据隐私与商业竞争问题,提出一个新的挑战——如何在不侵犯数据隐私法律条款的基础上,利用各个商业实体私人领域的孤立数据联合训练一个大规模语言模型?

在上述背景下,金智塔科技携手浙大研发团队,以创新的“联邦学习大语言模型”(Federated LLM,简称:“联邦LLMs”)解决了棘手的大模型数据隐私问题,满足数据要素市场多方数据融合应用的业务安全需求。

论文地址:https://arxiv.org/pdf/2307.08925.pdf

论文地址:https://arxiv.org/pdf/2307.08925.pdf

联邦学习是一种通过聚合参与客户端的模型更新来保护隐私的算法。大语言模型是一种基于预训练语言模型(PLM)开发的大语言模型,其参数大小和训练数据量的增加对其性能有积极影响。金智塔科技研发团队将FL和LLM范式无缝集成,形成联邦学习大语言模型。

该模型包括联邦LLM预训练、联邦LLM微调和联邦LLM提示工程三个关键组成部分。针对每个组成部分,金智塔科技研发团队讨论了它相对于传统LLM训练方法的优势,探讨了安全威胁和防御、隐私和隐私增强、计算效率等关键点,分析了FL和LLM集成所带来的新挑战,以及现有解决方案在“联邦LLMs”背景下可能面临的潜在障碍,最终提出了综合框架和具体的工程策略,以确保每个组成部分的有效性和安全性。

.png)

大语言模型(LLM)的问题

.png)

“联邦LLMs”预训练和微调流程

金智塔科技基于本次技术研究成果,创新提出大模型数据隐私最新解决方案。与以往单一的FL或LLM技术相比,“联邦LLMs”有三大显著的创新优势:

一、达到性能和成本的最优平衡

在“联邦LLMs”预训练模块,针对GPU算力、网速欠缺等计算资源匮乏的用户,允许其在开源基础模型上做后训练,在保证计算性能的前提下,降低原有成本,实现最优性价比;针对计算资源充足的用户,支持客户自定义模型架构,允许其建立可定制的检查点,赋予用户操作的自由度。

二、提升千倍算法效率

在“联邦LLMs”微调模块,允许用户进行全量微调,即直接微调预训练模型,支持DPSGD以及RGP;允许参数高效微调方法例如Adapter、LoRA、Prefix等,同时具有与之对应的DPSGD算法保证隐私,提升千倍的建模算法效率。

三、提高建模灵活度和智能化

在“联邦LLMs”提示工程模块,针对用户特定的任务,提供了联邦环境下的硬提示建模;对于任务界限不清晰的情况,允许其使用软提示提高模型泛化性,灵活匹配用户建模需求,提高过程智能化。

此次研究成果不仅揭示了大模型数据隐私的解决方案,还为未来在这一领域的研究和发展提供了见解。进一步研究“联邦LLMs”在推进各领域数据要素安全流通的落地应用具有重要意义。

在业务层面,“联邦LLMs”可应用于金融领域的各类分析,无论是在消费金融、保险、投资金融,或是税务咨询、投资组合建议等方面,“联邦LLMs” 可实现更精准、更及时的金融数据生成任务,预测金融产品的市场表现,进行金融舆情分析和客户情绪管理,节约互动成本,改进客户服务和提升用户体验。

在生物医学领域,基于“联邦LLMs”可以实现更精准的模型结果预测,更好地完成医学研究数据和临床保健数据的生成任务,并取得令人印象深刻的性能结果。比如针对消费者健康问题,在生成准确、有用的长格式答案之后,由医生小组和用户进行判断,这种方式有助于加快提出治疗建议,并根据患者特殊的健康状况向患者推荐个性化药物,最终提高治疗效果。“联邦LLMs”还可以直接根据患者过去的病史发展来预测他们潜在的疾病。

在法律领域,“联邦LLMs”技术可以帮助完成法定推理、法律判决、证据发展以及案例结果的预测任务,提升决策效率。

无论在何种领域,都要求需求方拥有足够多的高质量领域数据,虽然多家用户之间进行联合建模是个选项,但受限于隐私保护和商业竞争,直接合作和知识共享通常是很困难的,金智塔科技提出的“联邦LLMs”通过引入联邦学习方法,在不泄露各方隐私的条件下,完成联合建模,可以最大程度满足用户的需求,从而在未来应用到政务、金融等多领域,为实现数据要素安全流通与落地应用做好技术铺垫。

为您推荐

2023-09-12

2023-09-12

2023-09-12

2023-08-11

2023-08-07